«Федеральное государственное бюджетное образовательное учреждение высшего профессионального образования «Нижегородский государственный архитектурно-строительный университет» ...»

4.4. Выводы по 4 главе

В главе описан программный комплекс для визуализации виртуального глобуса и 3D-данных на глобусе и сделаны следующие выводы:

- Программный комплекс реализует режимы визуализации глобуса (глава 2), разработанный способ визуализации полупрозрачной поверхности глобуса, алгоритмы визуализации облаков точек и объемных данных (глава 3).

- Для низкоуровневой работы с трехмерной графикой, построения глобуса и графического интерфейса выбраны программные библиотеки OpenSceneGraph, osgEarth, Qt и другие. Комплекс имеет модульную архитектуру, позволяет использовать динамически подключаемые модули и работать одновременно с несколькими трехмерными сценами, содержащими разные данные.

- В случае глобуса существует особенность реализации стереоэффекта: необходимо динамически менять расстояние между виртуальными камерами в зависимости от расстояния до поверхности рельефа. Комплекс поддерживает стереоскопическую визуализацию на современном оборудовании.

- Существует несколько режимов навигации по сцене с виртуальным глобусом, каждый из которых подходит для своих задач. В программном комплексе реализованы разные режимы и переключение между ними.

- В случае стереоскопической визуализации возникают проблемы использования графического интерфейса пользователя и курсора мыши. Разные виды графических интерфейсов имеют свои недостатки. В качестве компромиссного решения выбран графический интерфейс на основе библиотеки Qt. Для взаимодействия с 3D-объектами реализован инструмент «Виртуальная лазерная указка», при котором вместо курсора мыши на поверхности 3D-объекта показывается маркер, который движется в соответствии с невидимым курсором мыши.

- Программный комплекс может использоваться для автоматизации рабочих местах в организациях, для анализа геопространственных данных в различных областях науки и при проектировании.

ЗАКЛЮЧЕНИЕ

В рамках данной работы исследованы методы визуализации виртуального глобуса, методы визуализации данных на глобусе, методы взаимодействия с глобусом в виртуальном окружении, в том числе с помощью графического интерфейса пользователя. Получены следующие результаты:

- Разработан способ визуализации виртуального глобуса с полупрозрачной поверхностью рельефа, который обеспечивает как надземный, так и подземный просмотр геометрических объектов под поверхностью глобуса и устраняет графические артефакты, вызванные перекрытием слоев рельефа и вспомогательной геометрии.

Предложенный способ можно использовать для решения задач реконструкции зданий и сооружений, в которых проектирование осуществляется на основе облака точек. Способ позволяет анализировать расположение проектируемого объекта относительно соседних зданий и окружающего рельефа, учитывать трассировку подземных коммуникаций и т.д.

- Разработан алгоритм визуализации облаков точек на глобусе с уровнями детализации, учетом особенностей глобуса, контролем плотности точек на экране и фильтрации по заданным критериям на графическом процессоре.

- Разработан алгоритм визуализации объемных данных, заданных в географической системе координат, который позволяет осуществлять просмотр данных сейсмотомографии, в том числе производить анимацию изменений во времени. Разработанные алгоритмы визуализации объемных данных и полупрозрачной поверхности глобуса могут быть использованы для представления и исследования процессов в земной коре с помощью данных сейсмотомографии для больших территорий. Источником объемных данных может быть также климатическое моделирование.

- Разработан программный комплекс, который обеспечивает визуализацию виртуального глобуса, данных и 3D-объектов на глобусе, взаимодействие с ними в виртуальном окружении на современном оборудовании. Разработанный программный комплекс может использоваться для организации автоматизированного рабочего места. Он обеспечивает удобную навигацию в трехмерном пространстве виртуального глобуса, стереоскопическую визуализацию с учетом разных масштабов, поддержку графического интерфейса пользователя.

Программный комплекс позволяет организовать стереовизуализацию в домашних условиях, либо на рабочих местах в организациях. Он позволяет работать с виртуальным глобусом и геопространственными данными в стерео и может являться основой для дальнейшего развития 3D-ГИС.

Результаты данной работы были частично использованы в следующих проектах: «Тренажер персонала Ленинградской АЭС», «Виртуальное Протвино», «Виртуальная Долина гейзеров», «Визуализация геофизических исследований», «Шуховская башня на Шаболовке», «Денисова пещера на Алтае».

Результаты работы демонстрируются посетителям Постоянно действующей выставки достижений РАН и музея Кроноцкого государственного природного биосферного заповедника.

БЛАГОДАРНОСТИ

Автор благодарен своему научному руководителю д.ф.-м.н. Афанасьеву В.О. за поддержку при написании диссертации.

Автор благодарен д.ф.-м.н., проф. Клименко С.В. за поддержку при написании диссертации и содействие в работе.

Автор благодарен к.ф.-м.н. Леонову А.В. за помощь и содействие в работе.

Автор благодарен Бакину Р.И. (ИБРАЭ РАН), Батурину Ю.М. (ИИЕТ РАН), Вагину А.И. (МРТИ РАН), Шпиленку Т.И. (КГПБЗ) за финансовую поддержку работы.

Автор благодарен Алешину В.П., Аникушкину М.Н., Белосохову Д.Е., Бугрову Н.В., Васину Ю.Г., Власенко А.В., Еремченко Е.Н., Жилиной Н.Д., Исламову Д.Р., Казанскому И.П., Клименко А.С., Конышеву В.А., Кулиеву В.М., Леженко А.И., Мещерину С.А., Петрову А.В., Петрухину В.А., Роткову С.И., Фролову П.В., Чеброву Д.В., Шурову А.И. за ценные замечания и дискуссии.

Автор благодарен Кугаенко Ю.А., Кулакову И.Ю., Ландеру А.В., Чеброву В.Н. за предоставленные данные для тестирования.

Автор благодарен Российскому фонду фундаментальных исследований за частичное финансирование исследования в рамках грантов 12-07-31043 мол_а, 10-07-00407-а.

СЛОВАРЬ ТЕРМИНОВ

Буфер трафарета (англ. stencil buffer) – дополнительный буфер в памяти, соответствующий по размеру выводимому кадру. Перед занесением цвета в буфер цвета позволяет проводить специальный тест, наряду с тестом глубины.

Виджет (англ. widget) - графический элемент для управления программой.

Граф сцены (англ. scene graph) - древовидная структура данных для логической и пространственной организации объектов трехмерной сцены.

Карта высот – изображение, в котором яркостью закодированы высоты поверхности.

Карта нормалей – изображение, в котором цветом закодированы нормали к поверхности.

Кэш (англ. cache) - хранилище промежуточных результатов работы для ускорения доступа к ним.

Приложение (англ. application) - прикладная компьютерная программа.

Рендеринг (англ. rendering) - процесс отрисовки, синтеза графического изображения

Тайл (англ. Tile) - прямоугольный элемент разбиения большого изображения.

Текстура (англ. Texture) – изображение, накладываемое на 3D-модель.

Трекинг (англ. Tracking) – отслеживание положения определенного объекта в пространстве с помощью специального оборудования.

Фреймворк (англ. framework) - промежуточное программное обеспечение, которое формирует каркас приложения и влияет на его архитектуру.

Шейдер (англ. shader) - программа для одной из ступеней графического конвейера, которая может включать матричные операции, вычисление освещения, текстурирование и эффекты постобработки.

СПИСОК ЛИТЕРАТУРЫ

- Леонов, А. В. 3D-документирование территории для систем виртуальной реальности/ А. В. Леонов, А. Е. Бобков, Е. Н. Ерёмченко // Вестник компьютерных и информационных технологий. - 2012. - Т. 9. - С. 13–17.

- Алейников, А. А. Интерактивное 3D-приложение «Виртуальная Долина гейзеров»/ А. А. Алейников, А. Е. Бобков, В. А. Дрознин // Компьютерные инструменты в образовании. - 2011. - Т. 4. - С. 41–49.

- Леонов, А. В. Виртуальное моделирование территории на основе данных дистанционного зондирования/ А. В. Леонов, А. А. Алейников, А. Е. Бобков // Известия высших учебных заведений. Геодезия и аэрофотосъёмка. - МИИГАиК, 2011. - Т. 2. - С. 46–52.

- Алешин, В. П. Устройство для тренировки восприятия виртуального пространства на основе адаптивной оптики/ В. П. Алешин, В. О. Афанасьев, А. Е. Бобков // Приборы. - 2012. - Т. 11. - С. 35–41.

- Бобков, А. Е. Разработка инструментария для показа стерео-презентаций из файлов в KML-формате/ А. Е. Бобков, И. П. Казанский, С. В. Клименко // MEDIAS 2010: Тр. междунар. науч. конф. - 2010. - С. 41–47.

- Бобков, А. Е. Разработка инструментария для показа стерео-презентаций из файлов в KML-формате/ А. Е. Бобков, И. П. Казанский, С. В. Клименко // ГрафиКон’2010: Тр. 20-й Междунар. конф. по компьютерной графике и зрению. - СПб., 2010. - С. 285–291.

- Бобков, А. Е. Исследование и разработка методов визуализации территорий на виртуальном глобусе/ А. Е. Бобков, С. В. Клименко, А. В. Леонов // MEDIAS 2011: Тр. междунар. науч. конф. - 2011. - С. 33–37.

- Бобков А. Визуализация сейсмических данных на виртуальном глобусе/ А. Бобков, А. Леонов, В. Чебров // ГрафиКон’2012: Сб. тр. 22 Междунар. конф. по компьютерной графике и зрению. - М.: МГУ, 2012. - С. 163–168.

- Aleshin, V. Visual 3D Perception of the Ski Course and Visibility Factors at Virtual Space/ V. Aleshin, V. Afanasiev, A. Bobkov // 2011 International Conference on Cyberworlds. - IEEE, 2011. - P. 222–226.

- Бобков, А. Е. Интерактивная визуализация 3D данных на виртуальном глобусе в стереоскопических системах (по материалам кандидатской диссертации)/ А. Е Бобков // Тр. Междунар. конф. по физико-технической информатике CPT2013. - Протвино-М.: Изд-во ИФТИ, 2013. - С. 75–84.

- Белосохов, Д. Е. Возможности 3D-визуализации для эффективного представления результатов научных исследований/ Д. Е. Белосохов, А. Е. Бобков, А. В. Леонов // Проблемы комплексного геофизического мониторинга Дальнего Востока России: Тр. третьей науч.-технической конф. - Петропавловск-Камчатский, 2011. - С. 347–351.

- Бакин, Р. И. 3D-реконструкция территории Ленинградской атомной электростанции для задач моделирования чрезвычайных ситуаций/ Р. И. Бакин, А. Е. Бобков, С. В. Клименко // Ситуационные центры и информационно-аналитические системы класса 4i. SC-IAS4i-VRTerro2011: тр. Междунар. науч. конф. – Протвино-М.: Изд. ИФТИ, 2011. – С.176-184.

- Dodge M., McDerby M., Turner M. The Power of Geographical Visualizations // Geographic Visualization Concepts Tools and Applications / Ed. by M. Dodge, M. McDerby, M. Turner. John Wiley and Sons, 2008. P. 1–10.

- Johnson, S. The Ghost Map: The Story of London’s Most Terrifying Epidemic - and how it Changed Science, Cities, and the Modern World/ S. Johnson. - Penguin, 2006.

- Tomlinson, R. A geographic information system for regional planning/ R. Tomlinson // GA Stewart, (ed.: Symposium on Land Evaluation, Commonwealth Scientific and Industrial Research Organization, MacMillan of Australia., Melbourne. 1968.

- Foresman, T. The history of geographic information systems: perspectives from the pioneers/ T. Foresman. - Prentice Hall PTR, 1998. ISBN: 0138621454.

- Coppock, J. The history of GIS/ J. Coppock, D. Rhind // Geographical information systems: Principles and applications. - 1991. - Vol. 1, № 1. - P. 21–43.

- Koninger, A. 3D-GIS for urban purposes/ A. Koninger, S. Bartel // GeoInformatica. - 1998. - Vol. 2, № 1. - P. 79–103.

- Stoter, J. 3D GIS, where are we standing/ J.Stoter, S. Zlatanova // Proceedings ISPRS Workshop on spatial, temporal and multi-dimensional data modelling and analysis. - Quebec, Canada, 2003.

- Дубинин, М. Отзыв на 3D ГИС Ульяновской области/ М. Дубинин. - 2011. URL: http://gis-lab.info/blog/2011-09/3dgis/.

- Емельянова, Г. ГИС сегодня: тенденции, обзор/ Г. Емельянова. - 2012. URL: http://isicad.ru/ru/articles.php?article_num=15737.

- Емельянова, Г. Трехмерные ГИС приходят в Россию. Autodesk Infrastructure Modeler как инструмент создания 3D ГИС/ Г. Емельянова, И. Спивак, А. Шатохин. - 2012. URL: http://isicad.ru/ru/articles.php? article_num=15195.

- 3D World Atlas. URL: http://en.wikipedia.org/wiki/3D_World_Atlas.

- Now a Virtual Globe, Not Just a World Atlas. 1997. URL: http://www.microsoft.com/en-us/news/press/1997/nov97/vglobepr.aspx.

- Bar-Zeev, A. The Word on Snow Crash and Google Earth/ A. Bar-Zeev. - URL: http://www.realityprime.com/blog/2007/09/the-word-on-snow-crash-and-google-earth/.

- Gore, A. The Digital Earth : Understanding our planet in the 21st Century/ A. Gore. - 1998. URL: portal.opengeospatial.org/files/?artifact_id=6210.

- Toutin T., Cheng P. QuickBird – a milestone for high-resolution mapping/ Toutin T., Cheng P. // Earth Observation Magazine. 2002. URL: ftp://ftp.geogratis.gc.ca/part6/ess_pubs/ 219/219909/13212.pdf.

- QuickBird specification. URL: http://www.digitalglobe.com/sites/default/ files/ QuickBird-DS-QB-PROD.pdf.

- SRTM. URL: http://www2.jpl.nasa.gov/srtm/.

- The History of the Modern Graphics Processor. URL: http://www. techspot.com / article/650-history-of-the-gpu/.

- Google Earth press release. URL: http://googlepress.blogspot.ru/ 2009/02/introducing-google-earth-50_02.html.

- Butler, D. Virtual globes: The web-wide world/ D. Butler // Nature. 2006. URL: http://www.nature.com/nature/journal/v439/n7078/full/439776a.html.

- Google Earth. URL: http://earth.google.com/intl/ru/.

- NASA World Wind. URL: http://worldwind.arc.nasa.gov/index.html.

- Turner, A. J. Introduction to Neogeography/ A. J. Turner // O’Reilly Media. - 2006.

- Дмитриева, В. Т. Неогеография и стереотипы: новые подходы в обучении/ В. Т. Дмитриева, Е. Н. Ерёмченко, С. В. Клименко, В. И. Кружалин // Вестник Московского городского педагогического университета. Серия: естественные науки. - 2009. - Т. 2. - С. 104–114.

- Берлянт, А. М. Картография как форма существования навигации/ А.М. Берлянт // Земля из космоса: наиболее эффективные решения. - 2010. - Т. 6. - С. 7–12.

- Неогеография vs. картография. URL: http://www.neogeography.ru/rus/ news/articles/neogeography-vs-cartography-part-1.html.

- i3D Virtual Globe. URL: http://www.fhnw.ch/habg/ivgi/forschung/i3d.

- Schafhitzel, T. Real-time rendering of planets with atmospheres/ T. Schafhitzel, M. Falk, T. Ertl // Journal of WSCG. 2007. URL: http://www.vis.uni-stuttgart.de/~falkmn/pubs/wscg07-schafhitzel.pdf.

- Schoning, J. Improving interaction with virtual globes through spatial thinking/ J. Schoning, B. Hecht, M. Raubal // Proceedings of the 13th international conference on Intelligent user interfaces - IUI ’08. - New York, New York, USA: ACM Press, 2008. - P. 129.

- Christen, M. The Future of Virtual Globes The Interactive Ray-Traced Digital Earth/ M. Christen // ISPRS Congress Beijing. - 2008.

- Bernardin, T. et al. Crusta: A new virtual globe for real-time visualization of sub-meter digital topography at planetary scales/ T. Bernardin, E. Cowgill, O. Kreylos // Computers & Geosciences. 2011. Vol. 37, no. 1. P. 75–85.

- Nebiker, S. Virtual Globes: Tech. rep./ S. Nebiker, S. Bleisch, E. Gulch. - 2010.

- Christen, M. Large Scale Constraint Delaunay Triangulation for Virtual Globe Rendering/ M.Christen, S. Nebiker // Advances in 3D Geo-Information Sciences/ Ed. by T. H. Kolbe, G. Konig, C. Nagel. - Berlin, Heidelberg: Springer Berlin Heidelberg, 2011. - Lecture Notes in Geoinformation and Cartography. - P. 57–72.

- Nebiker, S. Rich point clouds in virtual globes – A new paradigm in city modeling?/ S. Nebiker, S. Bleisch, M. Christen// Computers, Environment and Urban Systems. - 2010. - Vol. 34, no. 6. - P. 508–517.

- Bleisch, S. Evaluating the appropriateness of visually combining quantitative data representations with 3D desktop virtual environments using mixed methods: Ph. D. thesis / S Bleisch. - 2011. - P. 208.

- Cozzi, P. 3D Engine Design for Virtual Globes. A K Peters/ P. Cozzi, K. Ring. - CRC Press, 2011. - P. 520. ISBN: 1568817118.

- Outerra. URL: http://outerra.blogspot.ru/.

- Руководство разработчика API Google Earth. URL: https://developers.google.com/earth/documentation/index?hl=ru.

- NASA World Wind Java SDK. URL: http://worldwind.arc.nasa.gov/java/.

- osgEarth. URL: http://osgearth.org/.

- Tile Feature Service. URL: http://wush.net/trac/osgearth/ wiki/HowToGenerateTFS.

- Web Map Service specification. URL: http://portal.opengeospatial.org/ files/?artifact_id=14416.

- Tile Map Service specification. URL: http://wiki.osgeo.org/wiki/ Tile_Map_Service_Specification.

- Web Map Tile Service specification. URL: http://portal.opengeospatial.org/ f iles/?artifact_id=35326.

- Web Coverage Service specification. URL: http://portal.opengeospatial.org/ files/?artifact_id=41437.

- Web Feature Service specification. URL: http://portal.opengeospatial.org/ files/?artifact_id=39967.

- KML Reference. URL: http://code.google.com/apis/kml/ documentation/kmlreference.html.

- KML Specification. URL: http://www.opengeospatial.org/standards/kml/.

- ESRI Shapefile Technical Description. URL: http://www.esri.com/ library/whitepapers/pdfs/shapefile.pdf.

- Fan, M. A review of real-time terrain rendering techniques/ M. Fan, M. Tang, J. Dong// 8th International Conference on Computer Supported Cooperative Work in Design. - IEEE. - P. 685–691.

- White M. Real-Time Optimally Adapting Meshes: Terrain Visualization in Games // International Journal of Computer Games Technology. - 2008. – P. 1–7. URL: http://www.hindawi.com/journals/ijcgt/2008/753584/.

- Livny, Y. Seamless patches for GPU-based terrain rendering/ Y. Livny, Z. Kogan, J. El-Sana // The Visual Computer. - 2009. - Vol. 25, no. 3. - P. 197–208.

- Asirvatham, A. Terrain Rendering Using GPU-Based Geometry Clipmaps/ A. Asirvatham, H. Hoppe. - 2004. - P. 27–45. URL: http://research.microsoft.com/en-us/um/people/hoppe/gpugcm.pdf.

- Gorski, K. M. et al. HEALPix: A Framework for High Resolution Discretization and Fast Analysis of Data Distributed on the Sphere/ K. M. Gorski, E. Hivon, A. J. Banday // The Astrophysical Journal. 2005. Vol. 622, no 2. P. 759–771.

- Dana, P. H. Geodetic Datum Overview / P. H. Dana. - URL: http://www.colorado.edu/ geography/gcraft/notes/datum/datum.html.

- Геоцентрическая и геодезическая системы координат. URL: http://www.astronet.ru/db/msg/1190817/node25.html.

- Kemen, B. Logarithmic Depth Buffer/ B. Kemen. - URL: http://www.gamasutra.com/blogs/BranoKemen/20090812/2725/Logarithmic_Depth_Buffer.php.

- Ulrich, T. Rendering Massive Terrains using Chunked Level of Detail Control/ T. Ulrich // Proceedings of the 2002 ACM SIGGRAPH conference. - 2002.

- Shreiner D. OpenGL Programming Guide. 7 edition. Addison-Wesley, 2009. P. 1019.

- Blinn, J. F. Models of light reflection for computer synthesized pictures/ J. F. Blinn // ACM SIGGRAPH Computer Graphics. - 1977. - Vol. 11, no. 2. - P. 192–198.

- NASA WMS. URL: http://neowms.sci.gsfc.nasa.gov.

- Nishita, T. Display of the earth taking into account atmospheric scattering/ T. Nishita, T. Sirai, K. Tadamura, E. Nakamae // Proceedings of the 20th annual conference on Computer graphics and interactive techniques -SIGGRAPH ’93. - 1993. no. 2. - P. 175–182.

- O’Neal, S. Accurate atmospheric scattering/ S. O’Neal // GPU Gems. -2005. - Vol. 2. - P. 253–268. URL: http://http.developer.nvidia.com/GPUGems2/ gpugems2_chapter16.html.

- Bruneton, E. Precomputed Atmospheric Scattering/ E. Bruneton, F. Neyret // Computer Graphics Forum. - 2008. - Vol. 27, no. 4. - P. 1079–1086.

- Harris, M. J. Real-Time Cloud Rendering/ M. J. Harris, A. Lastra // Computer Graphics Forum. 2001. Vol. 20, no. 3. P. 76–85.

- Wang, N. Realistic and Fast Cloud Rendering/ N. Wang // Proceedings of the SIGGRAPH 2003 conference. - 2003. - P. 1–17.

- Bruneton, E. Real-time Realistic Ocean Lighting using Seamless Transitions from Geometry to BRDF/ E. Bruneton, F. Neyret, N. Holzschuch // Computer Graphics Forum. - 2010. - Vol. 29, no. 2. - P. 487–496.

- Wimmer, M. Light space perspective shadow maps/ M. Wimmer, D. Scherzer, W. Purgathofer// Proceeding EGSR’04 Proceedings of the Fifteenth Eurographics conference on Rendering Techniques. - Eurographics Association, 2004. - P. 143–151.

- Lagae, A. C. T. et al. State of the Art in Procedural Noise Functions/ A. Lagae, S. Lefebvre, D Rerose // EG 2010-State of the Art Reports. - 2010.

- Everitt C. Interactive Order-Independent Transparency: Tech. rep.: 2001.

- OpenGL depth buffer. URL: http://www.opengl.org/archives/ resources/faq/technical/depthbuffer.htm.

- Baker, S. Learning to Love your Z-buffer/ S. Baker. - URL: http://www.sjbaker.org/ steve/omniv/love_your_z_buffer.html.

- Horizon culling. URL: http://blogs.agi.com/insight3d/index.php/ 2008/04/18/horizon-culling/.

- Lloyd, B. Horizon occlusion culling for real-time rendering of hierarchical terrains/ B. Lloyd, P. Egbert. - 2002. - P. 403–410. - URL: http://dl.acm.org/ citation.cfm?id=602099.602162.

- Геологическая служба США (USGS). URL: http://usgs.gov.

- Камчатский филиал Геофизической РАН. URL: http://www.emsd.ru/.

- Середович, В. А. Наземное лазерное сканирование/ В. А. Середович, А. В. Комиссаров, Д. В. Комиссаров, Т. А. Широкова. - Новосибирск, 2009. - P. 261.

- Rusu, R. B. 3D is here: Point Cloud Library (PCL)/ R. B. Rusu, S. Cousins // Robotics and Automation (ICRA): 2011 IEEE International Conference. - 2011.- P.1–4.

- Sainz, M. Point-based rendering techniques/ M. Sainz, R. Pajarola // Computers & Graphics. - 2004. - Vol. 28, no. 6. - P. 869–879.

- Linsen, L. Point cloud representation/ L. Linsen. - 2001. URL: http://geom.ibds.kit.edu/papers/point_clouds.pdf.

- Botsch, M. High-Quality Point-Based Rendering on Modern GPUs/ M. Botsch, L.Kobbelt // PG ’03: Proceedings of the 11th Pacific Conference on Computer Graphics and Applications, IEEE Computer Societ. - Washington, DC, USA, 2003- P. 335.

- Rosenthal, P. Image-space point cloud rendering/ P. Rosenthal, L. Linsen // Proceedings of Computer Graphics International. - 2008. - P. 136–143.

- Schnabel, R. A Parallelly Decodeable Compression Scheme for Efficient Point-Cloud Rendering/ R.Schnabel, S.Moser, R.Klein // Eurographics Symposium on Point-Based Graphic. - 2007.

- Schnabel, R. Octree-based Point-Cloud Compression/ R. Schnabel, R. Klein // Eurographics Symposium on Point-Based Graphic. - 2006. - P. 111–120.

- Mitra, N. J. Estimating surface normals in noisy point cloud data/ N. J. Mitra, A. Nguyen, L. Guibas // International Journal of Computational Geometry & Applications. - 2004. - Vol. 14. - P. 261–276.

- Bruton, D. Approximate RGB values for Visible Wavelengths/ D. Bruton. - URL: http://www.physics.sfasu.edu/astro/color/spectra.html.

- OpenGL Shading Language specification. URL: http://www.opengl.org/ registry/ doc/GLSLangSpec.Full.1.20.8.pdf.

- Каталог землетрясений USGS. URL: http://earthquake.usgs.gov/ earthquakes/feed/.

- Кулаков, И. Ю. Геодинамические процессы в коре и верхней мантии земли по результатам региональной и локальной сейсмотомографии: диссертация на соискание ученой степени доктора геолого-минералогических наук/ И. Ю. Кулаков. - ИГМ СО РАН, 2007.

- Koulakov, I. Feeding paths of the Kluchevskoy volcano group (Kamchatka) from the results of local earthquake tomography/ I. Koulakov, E. I. Gordeev, N. L. Dobretsov // Geophys. Res. Lett. - 2011. - Vol. 38.

- Lorensen W. E., Cline H. E. Marching cubes: A high resolution 3D surface construction algorithm / W. E. Lorensen, H. E. Cline // ACM SIGGRAPH Computer Graphics. - 1987. - Vol. 21, no. 4. - P. 163–169.

- Drebin, R. A. Volume rendering/ R. A. Drebin, L. Carpenter, P. Hanrahan // ACM SIGGRAPH Computer Graphics. - 1988. - Vol. 22, no. 4. - P. 65–74.

- Engel, K. Real-time volume graphics/ K. Engel, M. Hadwiger, J. M. Kniss // Proceedings of the conference on SIGGRAPH 2004 course notes GRAPH ’04. - 2004. - P. 29.

- Гаврилов, Н. Стерео-визуализация научных и медицинских объемных данных трассировкой лучей в реальном времени/ Н. Гаврилов, А. Белокаменская// ГрафиКон’2010: Тр. 20-й Междунар. конф. по компьютерной графике и зрению. – СПб., 2010. - С. 350–352.

- Гаврилов Н., Турлапов В. Качественная объёмная визуализация гигавоксельных массивов в блочном представлении на примерах данных из медицины/ Н. Гаврилов, В. Турлапов // ГрафиКон’2012: Тр. 22-й Междунар. конф. по компьютерной графике и зрению. – М.: МГУ, 2012. - С. 174–179.

- Боголепов, Д. Высококачественная объемная визуализации в реальном времени/ Д. Боголепов, И. Бугаев, Д. Сопин // ГрафиКон’2012: Тр. 22-й Междунар. конф. по компьютерной графике и зрению. – М.: МГУ, 2012. - P. 169–173.

- Beyer, J. GPU-based Multi-Volume Rendering of Complex Data in Neuroscience and Neurosurgery: Ph. D. thesis/ J. Beyer. - 2009.

- Bowring, B. R. Transformation from spatial to geographical coordinates/ B. R. Bowring // Survey Review. - 1976. - Vol. 23, no. 181. - P. 5.

- Клименко, С. В. AVANGO. Cистема разработки виртуальных окружений/ С. В. Клименко, И. Н. Никитин, Л. Д. Никитина. – М.-Протвино, 2006.

- Mine, M. Virtual environment interaction techniques/ M.Mine // UNC Chapel Hill computer science technical report. - 1995. URL: http://lsc.univ-evry.fr/~davesne/ens/pub/virtual_environment_interaction_techniqu_129302.pdf.

- Robinett, W. Implementation of flying, scaling and grabbing in virtual worlds/ W. Robinett, R. Holloway // Proceedings of the 1992 symposium on Interactive 3D graphics - SI3D ’92. - New York, New York, USA: ACM Press, 1992. - P. 189–192.

- Stannus, S. Gestural navigation in Google Earth/ S. Stannus, D. Rolf, A. Lucieer, W. Chinthammit // Proceedings of the 23rd Australian Computer-Human Interaction Conference on - OzCHI ’11. - New York, USA: ACM Press, 2011. - P. 269–272.

- Bonfigli, M. E. The Aksum project: a VR GIS for a 3D inclusive interaction with an archaeological landscape/ M. E. Bonfigli, M. Forte, A. Guidazzoli // Bar international series. - 2003. - Vol. 1227. - P. 1–5.

- NVIDIA 3d Vision. URL: http://www.nvidia.com/object/3d-vision-glasses.html.

- OpenSceneGraph. URL: http://openscenegraph.org.

- Qt framework. URL: http://qt-project.org.

- Awesomium. URL: http://awesomium.com.

- DirectInput. URL: http://msdn.microsoft.com/en-us/library/windows/ desktop/ee416842(v=vs.85).aspx.

- Microsoft Kinect. URL: http://www.microsoft.com/en-us/kinectforwindows.

- Афанасьев, В. О. Системы 3D-визуализации индуцированной виртуальной среды: Ph. D. Thesis/ В. О. Афанасьев. - 2007. - P. 211.

- Elsaesser, T. James Cameron’s Avatar: access for all/ T. Elsaesser // New Review of Film and Television Studies.- 2011. - Vol. 9, no. 3. - P. 247–264.

- Beiser, L. Anaglyph Stereoscopy/ L.Beiser. - 1979.

- Dubois, E. A projection method to generate anaglyph stereo images/ E. Dubois // 2001 IEEE International Conference on Acoustics, Speech, and Signal Processing. Proceedings (Cat. No.01CH37221). - IEEE, 2001. - Vol. 3. - P. 1661–1664.

- Jorke, H. Infitec-a new stereoscopic visualisation tool by wavelength multiplex imaging/ H. Jorke, M. Fritz // Proceedings of Electronic Displays. - 2003. URL: http://jumbovision.com.au/files/Infitec_White_Paper.pdf.

- NVIDIA Quadro Quad Buffered Professional Stereo Technology. URL: http://www.nvidia.com/object/quadro_stereo_technology.html.

- OpenGL 4.3 specification. URL: http://www.opengl.org/registry/doc/ glspec43.core.20120806.pdf.

- Gateau, S. Implementing Stereoscopic 3D in Your Applications/ S. Gateau, S. Nash. - 2010. - URL: http://www.nvidia.com/content/GTC-2010/pdfs/ 2010_GTC2010.pdf.

- Zhai, S. Human performance in six degree of freedom input control: Ph. D. thesis/ S. Zhai. - 1995. - P. 179.

- 3d connexion. URL: http://www.3dconnexion.com/.

- Shotton, J. Real-time human pose recognition in parts from single depth images/ J. Shotton, T. Sharp, A. Kipman // Communications of the ACM. 2013. Vol. 56, no. 1. P. 116–124.

- Azimi, M. Skeletal Joint Smoothing White Paper / M. Azimi. - URL: http://msdn.microsoft.com/en-us/library/jj131429.aspx.

- OpenNI. URL: http://www.openni.org/.

- Boulos, M. N. K. Web GIS in practice X: a Microsoft Kinect natural user interface for Google Earth navigation/ M. N. K. Boulos, B. J. Blanchard, C. Walker // International journal of health geographics. - 2011. - Vol. 10. - P. 45.

- Leap Motion. URL: https://www.leapmotion.com/.

- Google Earth 7.1 released. URL: http://www.gearthblog.com/blog/archives/ 2013/04/google-earth-7-1-released-adds-support-for-leap-motion.html.

- Фурса, М. В. Исследование и разработка математического и программного обеспечения оптичеких систем слежения реального времени для приложений виртуального окружения: Ph. D. thesis. - 2009. - С. 132.

- Face Tracking library. URL: http://msdn.microsoft.com/en-us/library/jj130970.aspx.

- Global Imagery Browse Services. URL: http://earthdata.nasa.gov/about-eosdis/system-description/global-imagery-browse-services-gibs.

- OpenWeatherMap. URL: http://openweathermap.org/.

- DIVA GIS. URL: http://www.diva-gis.org/gData.

- OpenStreetMap. URL: http://www.openstreetmap.org/.

- Bourke, P. 3D Stereo Rendering Using OpenGL (and GLUT)/ P. Bourke. - 1999.URL: ftp://ftp.sgi.com/opengl/contrib/kschwarz/GLUT_INTRO/SOURCE/ PBOURKE/ index.html

ПРИЛОЖЕНИЕ А. Источники геоданных

Существуют различные данные ДДЗ в свободном доступе в интернете, которые можно использовать для создания собственного глобуса.

Изображения Земли

Blue Marble Next Generation — самая известная коллекция изображений с разрешением 500м/пк. Создана NASA путем обработки снимков со спутника MODIS, сделанных в 2004 году. Имеются изображения для всех 12ти месяцев. Изображения 3х типов: плоские, с данными топографии, с данными топографии и батиметрии.

MODIS — спутниковые снимки с аппаратов MODIS, которые были запущены на спутниках Терра (1999) и Аква (2002). Максимальное разрешение 250м/пк. Обновляются раз в день для всей Земли в нескольких спектральных диапазонах.

Landsat — спутниковые снимки, сделанные спутником Landsat-7, который был запущен в 1999 году. Максимальное разрешение 15м/пк. Сделаны в нескольких спектральных диапазонах.

Высотные данные

GTOPO30 — глобальный набор высотных данных с разрешением 30 угловых секунд (~1км/пк). Создан в 1996 году Геологической службой США (USGS). Данные собраны из различных источников растровой и векторной топографической информации.

NASA Shuttle Radar Topography Mission (SRTM) — международный проект по получению высотных данных высокого разрешения между 56 S и 60 N. В феврале 2000 года была проведена радарная съемка земной поверхности с шаттла Эндевор в ходе 11ти-дневной миссии. Разрешение исходных данных — 1 угловая секунда (~30 метров/пк). Но данные такого разрешения были получены только для территории США. Для остальной части мира разрешение — 3 угловые секунды (~90 метров/пк). Вертикальная ошибка — примерно 16 метров. Исходные данные проекта SRTM содержат дыры, т.е. области без высотных данных. Эти дыры присутствуют в горных и пустынных районах. Для заполнения дыр применяются различные алгоритмы интерполяции.

ASTER Global Digital Elevation Model (ASTER GDEM) — самая полная на данный момент цифровая модель рельефа между 83 S и 83 N с разрешением 30м/пк. Выпущена в 2009 году. Получена на основе обработки стерео-пар спутниковых снимков с аппарата ASTER. Вертикальная ошибка составляет 20 метров.

Батиметрия

ETOPO1 — цифровая модель рельефа всей Земли, включая рельеф морского дна с разрешением 1 угловая минута (~1.8км/пк). Выпущена Национальным управлением океанических и атмосферных исследований США (NOAA).

SRTM30_PLUS — цифровая модель рельефа всей Земли, включая рельеф морского дна с разрешением 30 угловых секунд (~1км/пк).

Прочие данные

NASA регулярно публикует научные растровые данные для всей Земли [73, 140]. Сюда входят: температура суши и моря, толщина аэрозольного слоя, концентрация углекислого газа, плотность растительного покрова, альбедо поверхности.

Другие организации также выкладывают геопривязанные данные. Геологическая служба США (USGS) в реальном времени публикует землетрясения, происходящие в мире [100]. Также доступны архивные данные по землетрясениям. Проект OpenWeatherMap публикует текущие погодные данные в векторном и растровом форматах [141]. На сайте проекта DIVA-GIS опубликованы свободные векторные данные низкого разрешения для всех стран мира [142].

OpenStreetMap — картографический сервис, построенный про принципу вики [143]. Этот сервис позволят создавать и редактировать векторную карту Земли. Любой пользователь может нарисовать дороги, задать им свойства, отметить здания, парки, леса, реки, объекты инфраструктуры. Теоретически, возможны акты вандализма, когда вносятся заведомо недостоверные данные. Но за счет очень большого количества участников, которые отслеживают корректность данных, можно почти не сомневаться в точности. Данные сервиса свободно доступны в растровом и векторном форматах.

ПРИЛОЖЕНИЕ Б. Шейдеры для объемной визуализации

1-й проход

Вершинный шейдер:

varying vec3 position;

void main(void)

{

position = gl_Vertex.xyz;

gl_Position = ftransform();

}

Фрагментный шейдер:

varying vec3 position;

void main(void)

{

gl_FragColor = vec4(position, 1.0);

}

2-й проход

Вершинный шейдер:

varying vec3 position;

varying vec3 lightDirection;

varying vec4 baseColor;

varying vec4 texBackCoord; //coord in offscreen texture

void main(void)

{

position = gl_Vertex.xyz;

gl_Position = ftransform();

texBackCoord = gl_ModelViewProjectionMatrix * gl_Vertex;

texBackCoord /= texBackCoord.w;

texBackCoord += vec4(1.0, 1.0, 1.0, 0.0);

texBackCoord *= vec4(0.5, 0.5, 0.5, 1.0);

baseColor = vec4(1.0, 1.0, 1.0, 1.0);

vec4 lightPosition = gl_ModelViewMatrixInverse * gl_LightSource[0].position;

if (lightPosition[3]==0.0)

{

// directional light source

lightDirection = -normalize(lightPosition.xyz);

}

else

{

// positional light source

lightDirection = normalize((lightPosition-gl_Vertex).xyz);

}

}

Фрагментный шейдер:

uniform sampler3D baseTexture;

uniform sampler1D tfTexture;

uniform float tfScale;

uniform float tfOffset;

uniform sampler2D backTexture;

uniform float SampleDensityValue;

uniform float TransparencyValue;

uniform float AlphaFuncValue;

varying vec3 position;

varying vec4 baseColor;

varying vec4 texBackCoord; //coord in offscreen texture

const float _radiusEquator = 6378137.0;

const float _radiusPolar = 6356752.3142;

const float flattening = (_radiusEquator-_radiusPolar)/_radiusEquator;

const float _eccentricitySquared = 2.0*flattening - flattening*flattening;

const float lon1 = 2.094395102393;

const float lon2 = 3.141592653589;

const float lat1 = 0.174532925199;

const float lat2 = 1.221730476396;

const float z1 = -25000.0;

const float z2 = -600000.0;

vec3 getTexCoord(vec3 pos)

{

float p = sqrt(pos.x*pos.x + pos.y*pos.y);

float theta = atan(pos.z*_radiusEquator, (p*_radiusPolar));

float eDashSquared = (_radiusEquator*_radiusEquator - _radiusPolar*_radiusPolar) / (_radiusPolar*_radiusPolar);

float sin_theta = sin(theta);

float cos_theta = cos(theta);

float latitude = atan((pos.z + eDashSquared*_radiusPolar*sin_theta*sin_theta*sin_theta) / (p - _eccentricitySquared*_radiusEquator*cos_theta*cos_theta*cos_theta));

float longitude = atan(pos.y,pos.x);

float sin_latitude = sin(latitude);

float N = _radiusEquator / sqrt( 1.0 - _eccentricitySquared*sin_latitude*sin_latitude);

float height = p/cos(latitude) - N;

float s = (longitude - lon1) / (lon2 - lon1);

float t = (latitude - lat1) / (lat2 - lat1);

float z = (height - z2) / (z1 - z2);

return vec3(s, t, z);

}

void main(void)

{

vec3 pos0 = texture2D(backTexture, texBackCoord.st).xyz;

vec3 pos1 = position;

const float max_iteratrions = 2048.0;

float num_iterations = ceil(1.0/SampleDensityValue);

if (num_iterations<2.0) num_iterations = 2.0;

if (num_iterations>max_iteratrions)

{

num_iterations = max_iteratrions;

}

vec3 deltaPosCoord=(pos1-pos0).xyz/float(num_iterations-1.0);

vec3 curpos = pos0;

vec4 fragColor = vec4(0.0, 0.0, 0.0, 0.0);

while(num_iterations>0.0)

{

vec3 texcoord = getTexCoord(curpos);

float v = texture3D(baseTexture, texcoord).a * tfScale + tfOffset;

vec4 color = texture1D(tfTexture, v);

float r = color[3]*TransparencyValue;

if (r>AlphaFuncValue)

{

fragColor.xyz = fragColor.xyz*(1.0-r)+color.xyz*r;

fragColor.w += r;

}

if (fragColor.w<color.w)

{

fragColor = color;

}

curpos += deltaPosCoord;

--num_iterations;

}

fragColor.w *= TransparencyValue;

if (fragColor.w>1.0) fragColor.w = 1.0;

fragColor *= baseColor;

if (fragColor.w<AlphaFuncValue) discard;

if (length(pos0.xyz) < 0.01)

{

discard;

}

if (length(fragColor.rgb) < 0.01)

{

discard;

}

gl_FragColor = fragColor;

}

При разработке шейдеров использовались формулы и фрагменты кода из работ [117, 110].

ПРИЛОЖЕНИЕ В. Расчет стереоэффекта

Математика стереоэффекта подробно разобрана в работах [129, 144].

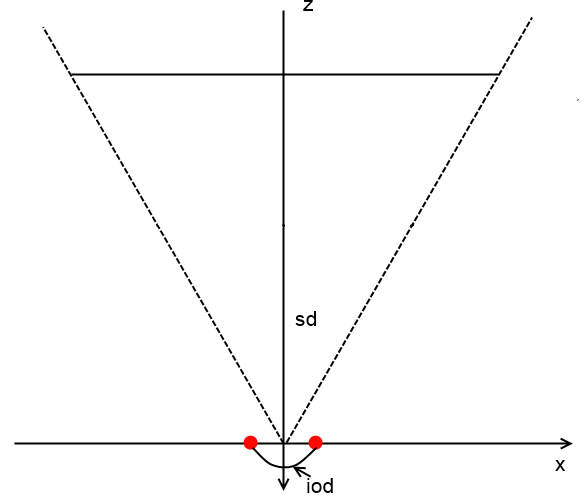

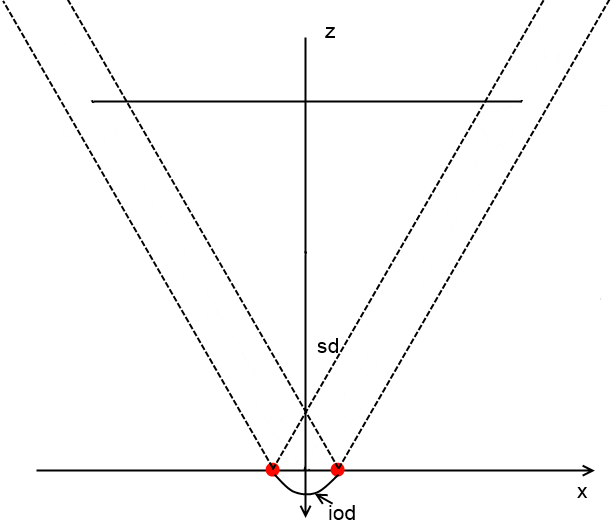

Пусть голова наблюдателя неподвижна и находится на расстоянии (screen distance) от экрана и смотрит точно в центр экрана. Глаза сдвинуты влево и вправо от положения головы на расстояние, где — расстояние между глазами (interocular distance). Вид сверху изображен на рис. В.1. На рисунке показаны оси координат видовой СК: ось X направлена вправо, а камера смотрит вдоль отрицательного направления оси Z.

|

| Рис. В.66. Вид сверху на главную камеру и положение глаз |

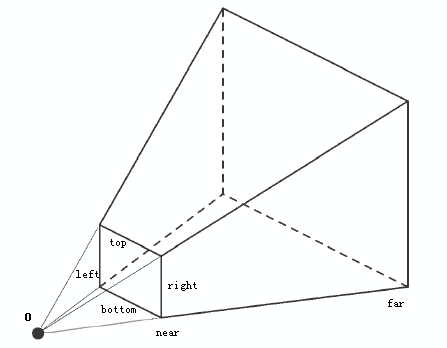

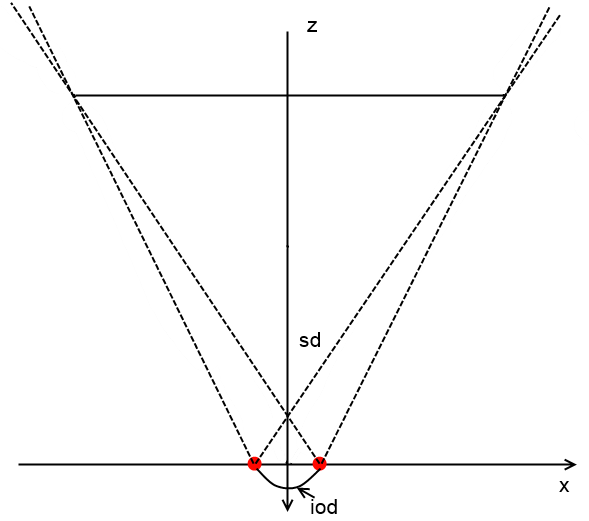

Состояние виртуальной камеры описывается 2мя основными матрицами: матрицей вида и матрицей проекции. В матрице вида заключено положение и ориентация камеры. В матрице проекции — параметры объема видимости. Объем видимости задается границами ближней плоскости отсечения (left, right, top, bottom) и расстояниями до ближней и дальней плоскостей отсечения (near, far) (рис. В.2).

Задача состоит в том, чтобы корректно посчитать матрицы вида и проекции для 2-х камер, соответствующих глазам. В рамках вышеописанных ограничений (голова зафиксирована относительно экрана) удобно хранить и вычислять изменение матриц для условной центральной камеры, которая соответствует голове. Например, алгоритмы навигации (параграф 4.3) должны возвращать именно параметры для головы наблюдателя. Это позволяет уменьшить связность между модулями навигации и стереоэффекта. Модуль навигации не должен ничего знать про стереоэффект и иметь возможность работать без стерео. Матрицы для виртуальных камер нужно вычислять путем домножения на корректирующие матрицы.

|

| Рис. В.67. Параметры матрицы проекции |

Простейший (и неправильный) подход к виртуальным камерам состоит в простом их сдвиге по оси X (рис. В.3). Этот подход не учитывает наличие экрана. Реальному экрану (монитору) перед пользователем соответствует виртуальный экран в трехмерной сцене. Здесь можно применить метафору окна. Экран — это окно, через которое пользователь смотрит на трехмерную сцену.

Поэтому корректным будет конфигурация камер с учетом экрана на рис. В.4. Можно заметить, что объем видимости становится не симметричным. Также если 3D-объект находится на бесконечности (очень далеко), то расстояние между его изображениями на экране должно равняться расстоянию между глазами (примерно 0.06м).

|

| Рис. В.68. Неправильный подход к стереоэффекту |

|

| Рис. В.69. Корректная конфигурация виртуальных камер |

Для корректных расчетов необходимо задать следующие параметры: ширину экрана, высоту экрана, расстояние до экрана и расстояние между глазами. Делать это необходимо в тех единицах, которые используются в приложении. Обычно это метры.

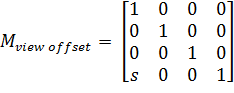

Для корректировки матрицы вида необходимо её домножить на матрицу сдвига по оси X на ![]()

![]() для одной камеры и на

для одной камеры и на ![]()

![]() для другой.

для другой.

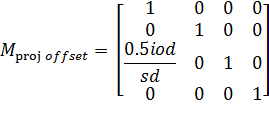

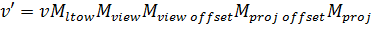

| (В.40) |

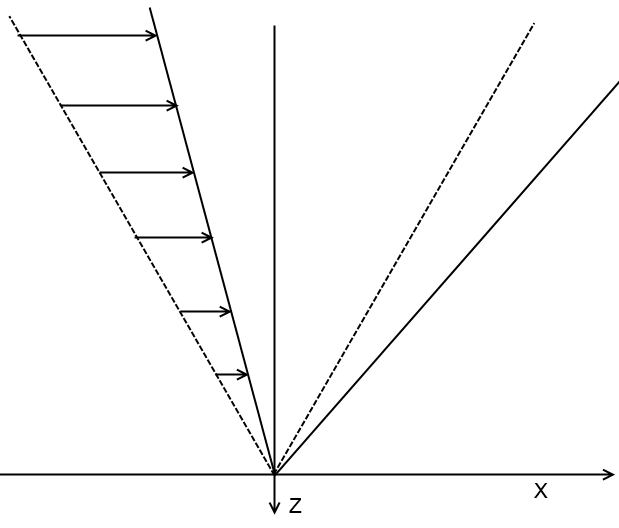

Исходная матрица проекции для условной центральной камеры — симметричная. Нужно её также домножить на корректирующую матрицу, которая изменяет форму области видимости. Изменение формы области можно достичь, если применить ко всем вершинам всех объектов смещение по оси X, пропорциональное расстоянию до камеры (рис. В.5).

|

| Рис. В.70. Корректировка объема видимости |

Матрица выглядит следующим образом:

| (В.41) |

Для правой камеры сдвиг будет в другую сторону.

Если всё это записать в матричной форме, то получится следующее:

| (В.42) |

Данные формулы используют реальные параметры в метрах: расстояние между глаз и расстояние до экрана. Поэтому ощущения «объемности» и расстояния до объектов будут примерно соответствовать ощущениям в реальной жизни. Но, как мы знаем, для дальних объектов на расстоянии больше 50м «объемность» почти не ощущается [122]. Земной шар из космоса представляется Земным диском. Аналогичная ситуация имеет место в виртуальном окружении. Действительно, параллакс для дальних объектов почти неотличим от расстояния между глазами (примерно 0.06м).

Но всё преимущество систем виртуального окружения состоит именно в ощущении объема. Для этого объект должен находиться в плоскости экрана и иметь размеры, сопоставимые с плоскостью экрана. Желательно, чтобы объект целиком умещался на экране. Тогда эффект будет максимальным: часть объекта будет казаться за экраном, часть — перед экраном, и благодаря этому глаза будут уставать меньше.

Но что, если объект слишком маленький (например, молекула) и находится очень близко к камере (меньше половины расстояния до экрана) или слишком большой (например, виртуальный глобус) и находится очень далеко (более чем в 100 раз дальше, чем экран)? В первом случае расстояние между изображениями для левого и правого глаза будет очень сильно расходиться, и глаза не смогут сфокусироваться. Во втором случае изображения будут на экране на расстоянии iod, модель будет казаться на бесконечности и никакого положительного эффекта «объемности» мы не почувствуем.

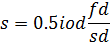

В этом случае можно пойти на сознательное искажение восприятия реального объема объекта, чтобы улучшить восприятие объекта в целом. Для очень больших объектов нужно всю сцену уменьшить в размерах, для маленьких — соответственно увеличить в размерах. Однако использование матрицы масштабирования нежелательно из-за возможных побочных эффектов. Вместо этого можно изменить параметры виртуальных камер. Если на рисунке В.4 раздвинуть камеры, то автоматически увеличится расстояние до экрана (плоскость пересечения объемов видимости будет считаться экраном). Как будто виртуальный наблюдатель вырос в размерах. Это равносильно уменьшению объекта. Удобно ввести параметр fd (fusion distance) — характерное расстояние до объекта. Это расстояние, на котором должен находиться виртуальный экран. Для объектов в плоскости экрана параллакс равен нулю. Отсюда и термин fusion — схождение, слияние.

Тогда параметр s для сдвига камер в матрице (В.2) будет считаться по формуле:

| (В.43) |

При этом матрица проекции останется без изменений.

ПРИЛОЖЕНИЕ Г. Аппаратное обеспечение

Спецификация аппаратного обеспечения, используемого для работы программного комплекса.

- Процессор CPU Intel Core i5-3450 (3.1 ГГц/4core/SVGA HD Graphics 2500/1+6Мб/77 Вт/5 ГТ/с LGA1155)

- Материнская плата ASUS P8Z77-V PRO/THUNDERBOLT (RTL) LGA1155 <Z77> 3xPCI-E+Dsub +DV+HDMI+miniDP/TB+GbLAN+WiFi SATA RAID ATX 4DDR-III

- Оперативная память Corsair Vengeance <CMZ8GX3M1A1600C10> DDR-III DIMM 8Gb <PC3-12800>

- Видеокарта 1Gb <PCI-E> DDR-3 PNY VCQ600(ATX)(V2)-T (OEM) DVI+DP <NVIDIA Quadro 600>

- Жесткий диск SSD 128 Gb SATA 6Gb/s OCZ Vertex 4 <VTX4-25SAT3-128G> 2.5"MLC+3.5"адаптер

- Жесткий диск HDD 1 Tb SATA 6Gb/s Western Digital Caviar Black <WD1002FAEX> 7200rpm 64Mb

- Стерео монитор LG d2343p основе черезстрочного стерео

- Microsoft Kinect for Windows

- Джойстик 3dconnexion SpaceNavigator